Deep Learning as a Service

Las aplicaciones del Deep Learning son infinitas.

- DES se centrará en 'Blockchain' e Inteligencia Artificial este año

- El gasto en sistemas de inteligencia cognitiva y artificial en Europa alcanzará los 1.500 millones de dólares en 2017

- NVIDIA y Audi firman un acuerdo para desarrollar un coche dotado con redes neuronales en 2020

- La computación cognitiva es la inteligencia artificial con un aspecto más humano

UN POCO DE HISTORIA

En 1956, durante la famosa conferencia de Darthmounth, Jon McCAthty acuño el término Inteligencia Artificial, definiéndola simplemente como: “La ciencia y el ingenio de hacer máquinas inteligentes". En la introducción de la conferencia se mencionaban, además, los objetivos de aquella joven ciencia que, cincuenta años después, aún se mantienen vigentes:

"Cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, ser descrito con tanta precisión que puede fabricarse una máquina para simularlo. Se intentará averiguar cómo fabricar máquinas que utilicen el lenguaje, formen abstracciones y conceptos, resuelvan las clases de problemas ahora reservados para los seres humanos, y mejoren por sí mismas"

Dos años después, en 1958, Frank Rosenblat desarrolló el PERCEPTRON, un algoritmo capaz de reconocer algunos patrones utilizando una red neuronal de dos niveles. Aunque pronto se demostró que sería necesaria mucha mayor complejidad para poder resolver incluso los problemas más sencillos, se esperaba que, con el tiempo, las redes neuronales fueran capaces de emular el funcionamiento del cerebro humano.

Lamentablemente, ni siquiera la llegada de la computación en paralelo en los años ochenta permitió lograr los avances prometidos por lo que la investigación en redes neuronales fue decayendo eclipsada por los SVM (Support Vector Machines), los algoritmos de clasificación no-lineal o los evolutivos.

Ha sido un agrio camino que ha mantenido ocupados a los investigadores durante casi cuatro décadas aunque parece que estamos cerca de ver su final gracias a...

EL APRENDIZAJE PROFUNDO

El aprendizaje profundo (el Deep Learning) es un término de nueva factura que engloba un conjunto de algoritmos que tratan de simular el funcionamiento básico del cerebro encadenando en cascada varias redes neuronales (más información...). El modelo no es nuevo, se basa en los trabajos de Kunihiko Fukushima quién propuso en los años 80 un algoritmo conocido como "neocognitron" en donde se empleaban varias redes para emular el funcionamiento de las neuronas del córtex visual primario.

En su interpretación moderna, se establece una jerarquía de redes neuronales capaces de procesar determinadas características de un conjunto de datos, desde las más básicas a las más complejas. Así los resultados de una red son empleados por el siguiente nivel para lidiar con un problema de mayor calado.

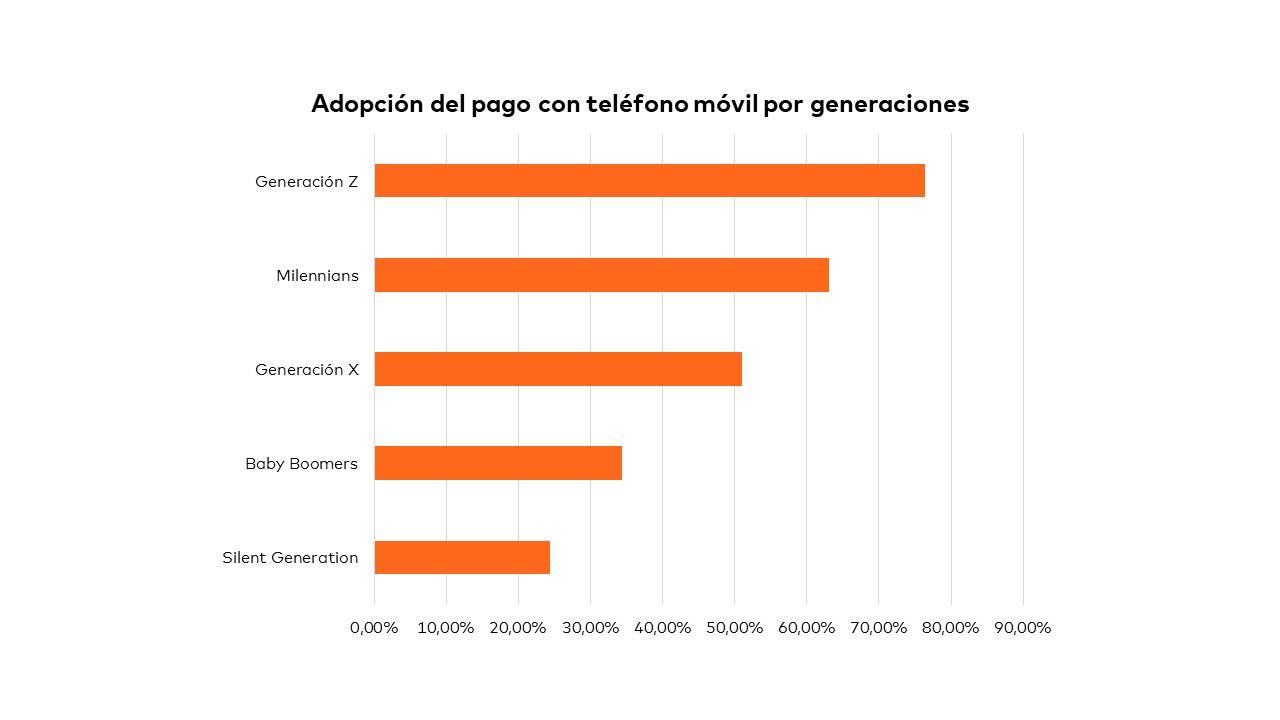

Buscadores inteligentes capaces de localizar los contenidos en función de preguntas expresadas en lenguaje natural, asistentes personales que conocen tus preferencias, sistemas capaces de reconocer los objetos que aparecen en una fotografía o de reconocimiento facial, clientes de correo electrónico que no sólo son capaces de clasificar los mensajes en función de su temática sino que, además, escriben la respuesta por ti.

Grandes promesas, desde luego, pero al alcance de muy pocos, pues este tipo de algoritmos requiere de una enorme potencia de procesamiento, grandes repositorios de información y equipos humanos con un profundo conocimiento técnico para entrenar a las redes neuronales.

ALQUILAR INTELIGENCIA

La inteligencia artificial está desempeñando un papel cada vez más esencial en las organizaciones. Sin embargo, muy pocas disponen de los recursos necesarios para poder afrontar proyectos que requieran de la aplicación de dichos algoritmos.

Afortunadamente, empresas como Google, Microsoft, IBM, Amazon o Facebook se encuentra inmersas en una carrera por acaparar el mercado de la Inteligencia Artificial de la que todos podemos beneficiarnos.

Los primeros kilómetros de esta carrera los dominó Amazon proponiendo tímidas soluciones donde se ofrecían predicciones muy básicas a partir de datos de usuario bajo el paraguas de Amazon ML. Sin embargo, a largo del año pasado, y gracias a la popularización del Deep Learning, han ido proliferando servicios mucho más interesantes sobre todo alrededor del procesamiento de lenguaje natural y la visión artificial.

A continuación, se explican las diferentes propuestas de estos atletas tecnológicos que están compitiendo en esta emocionante carrera.

PROCESAMIENTO DE LENGUAJE NATURAL

El procesamiento de lenguaje natural, ha sido uno de los problemas más complejo que se lleva abordando en toda la historia de la informática. Es obvio, que la comunicación humano-máquina está creciendo exponencialmente. Por todo ello por ejemplo IBM se ha esforzado en ofrecer uno de los más competitivos servicios:

- Natural Language Understanding permite analizar características semánticas del texto como pueden ser conceptos, entidades (menciones a personas, organizaciones, etc.), sentimientos, y relaciones entre otros.

- Tone Analyzer ayuda identificar el contexto emocional de las conversaciones.

- Personality Insights ofrece una comprensión más profunda de las características, necesidades y valores de la personalidad que ha escrito el texto.

Por otro lado, Microsoft dispone de Luis.Ai, su sistema de reconocimiento de Lenguaje natural, que facilita comprender la intención del usuario (pedir una taxi, buscar un restaurante, poner una alarma…) pudiendo además, utilizando Microsoft Text Analytics, conocer el estado de ánimo del interlocutor. Dentro de este ámbito Google también dispone de Google Cloud Natural Languaje con similares características. Ambas soluciones proporcionan un sistema que dotará a nuestras aplicaciones de una capacidad de conversación realista con un entrenamiento bajo.

Específicamente para servicios de voz, Amazon provee Alexa, el corazón de Amazon Echo basado en Amazon Lex que facilita la creación de skills (o habilidades) concretas para realizar tareas sencillas; es un producto muy orientado a controlar desde Amazon Echo el hogar (cambiar un video, encender una luz, realizar una llamada…).

Llama la atención como todas las compañías que disponen de asistentes virtuales (MS Cortana, Amazon Alexa, Google Now/Assistant, Facebook M y Siri) están proporcionando sus APIs de reconocimiento de lenguaje natural a precios realmente competitivos. Sin duda, el mercado de la comprensión lingüística es una de las disciplinas en esta apasionante carrera.

VISIÓN ARTIFICIAL

La visión artificial ha provocado el tener que replantearse cómo se estaban haciendo las cosas hasta ahora. Microsoft en este caso los ha acogido bajo Cognitive Services ofreciendo soluciones de propósito general muy completas para reconocer caras, emociones y contextos.

Amazon por su parte ha publicado recientemente un servicio homólogo con el nombre de Amazon Rekognition y Google sigue la misma línea con Cloud Video Intelligence aplicado en plataformas como YouTube que permite buscar fácilmente contenido o contextos en los videos sin necesidad de etiquetarlos manualmente.

Por otro lado, Facebook aunque no ofrece un servicio de este tipo directamente, si lo utiliza internamente para agregar automáticamente etiquetas a las imágenes que intenta, por el momento y sin mucho éxito, que pasen desapercibidas para los usuarios:

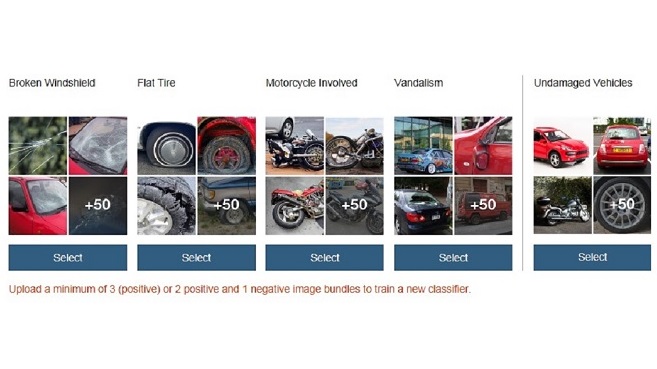

No tenemos que olvidar que la información que nos aportan estos modelos está totalmente reducida a los casos con los que han sido entrenados, es decir, no sabrán identificar un martillo por muy cotidiano que nos pudiera parecer si no hemos entrenado el modelo con fotos de esta herramienta.

En este sentido IBM con Watson Visual Recognition permite crear clasificaciones personalizadas de imágenes propias de una manera fácil e intuitiva.

Pero hay que destacar que aun siendo un servicio interesante y sencillo de utilizar, tiene sus limitaciones, como puede ser el reconocimiento facial, de emociones y la detección de detalles no llega tener la profundidad de modelos realizados, mediante unentrenamiento completo (full-training) con las diferentes herramientas y Frameworks de Deep Learning que veremos a continuación.

FRAMEWORKS

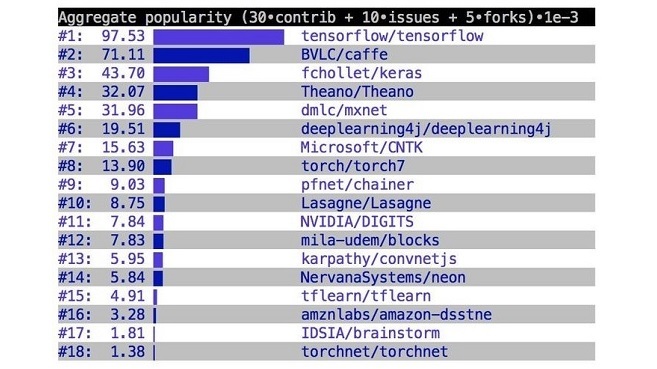

El objetivo de estos proveedores no es solo convencer a los usuarios, sino también a todos los desarrolladores que hay detrás de las aplicaciones machine learning, por lo que Google destacó liberando TensorFlow, haciendo más fácil y eficiente la creación y entrenamiento de redes neuronales. Consiguiendo popularizarse muy rápidamente a las herramientas “tradicionales” como son Torch, Theano y Caffe.

Por otro lado, Microsoft dispone de CNTK , el cual es otro conjunto de herramientas de aprendizaje profundo unificado que describe las redes neuronales como una serie de pasos computacionales a través de un gráfico dirigido, como si de una receta se tratase añadiendo los ingredientes necesarios para realizar y combinar fácilmente tipos de modelos populares. Además, hace ya tiempo publicó también MS COCO (Common Objects in Context), un dataset con más de 300.000 imágenes segmentadas y catalogadas para fines científicos. Amazon por su parte ha liberado DSSTNE, una biblioteca para el entrenamiento y la implementación de modelos de recomendación.

ARTICULOS

Por último, es necesario cautivar también a quizás el que pudiera ser el público más exigente, me refiero a los científicos de datos. Intentar captar su interés mediante aportaciones al mundo científico puede parecer atractivo que para así se fijen en sus productos y los puedan elegir como preferidos. En este caso, Facebook, IBM, Google y Microsoft se apresuran en publicar sus conclusiones para diferenciarse como líderes, sabedores de que la estrategia de copiar y pegar poco sentido tiene en este área. Incluso Apple, finalmente ha comenzado a compartir parte de la magia de sus investigaciones en inteligencia artificial.

CONCLUSIONES

Esta carrera no será un sprint, sino toda una maratón dónde estos hitos sólo han recorrido los primeros metros. Por tanto, quedan aún muchos kilómetros de dura complejidad en las carreteras del machine learning para encontrar el límite de la precisión que este tipo de tecnologías puede ofrecer. Skynet puede esperar.

|

Raúl De la Fuente LopesBusiness Analytics Arquitect en Altran Tessella y responsable de proyectos de Inteligencia Artificial en Altran Innova. Sus campos de interés son: Big data, Inteligencia Artificial, Blockchain, open source y la neurociencia. Madrid, España. |